Vertrauen, Menschlichkeit und Fairness bewegen uns – Ein KI-Verfahren hilft 2020 erstmals dabei, das operativ einzulösen: Als Konsistenzprüfung im Rahmen der Tantieme-Bewertung.

Die viadee Tantieme ist eine Möglichkeit der Erfolgsbeteiligung für alle viadee’ler*innen. Sie ist auch eine Art persönliche Retrospektive eines Jahres und belohnt die Beiträge des Einzelnen in einem Jahr. Dafür gilt es, diese Beiträge zu bewerten. Das erfolgt durch wenige quantitative Größen und viele Einschätzungen von Aspekten wie der eigenen Weiterbildung, der Unterstützung von Vertrieb und Personal oder auch dem Beitragen neuer Ideen.

Herausforderung: Gerechte, begründbare Tantiemebewertung

Diese werden erhoben und manuell auf gleiche Bewertungsmaßstäbe geeicht und dann aufwendig im Personalkreis konsolidiert. Mit mehr als 150 Mitarbeiter*innen und 16 Bewertungsdimensionen ist das zu einer kaum zu überblickenden Mammutaufgabe geworden.Um Fairness zu maximieren und auch im Personalgespräch mit den einzelnen Mitarbeiter*innen auskunftsfähig zu sein, ist das Mittel der Wahl zur Qualitätssicherung der Paar-Vergleich. Manche Mitarbeiter*innen tun in einem Jahr sichtbar ähnliche Dinge ähnlich erfolgreich: Sind diese dann auch ähnlich bewertet? Diese Frage beantwortet die Konsolidierungsrunde pro Kriterium für alle bewerteten Mitarbeiter*innen.

Auch der Vergleich mit dem Vorjahr hilft bei der Orientierung: Haben sich Projekteinsätze oder Rollen verändert? War das Engagement in F&E, Vertrieb oder Personal gleichbleibend oder sind Aufgaben ausgelaufen oder dazugekommen? Die Zahl der potenziellen Vergleiche macht beides anstrengend.

Wie kann eine Data Science-Unterstützung beim Abgleich helfen?

Es liegt nahe, hier moderne Data Science-Verfahren einzubringen: Als Unterstützung, nicht um die manuelle Bewertung zu ersetzen, sondern um die Diskussion der Bewertungsrunde effizient an die richtigen Stellen zu führen.

Für die Rückschau auf 2019 habe ich das erstmalig versucht: Auf einem von der Personalleitung anonymisierten Datensatz und mit hohem Anspruch an die Vertraulichkeit der Daten. Zeitlich waren wir kurz vor dem Ende der Diskussionsrunde aktiv – im Sinne einer Qualitätssicherung in beide Richtungen: Ich wollte die Idee prüfen, aber auch schon Impulse und Konsistenzprüfungen mit in die Diskussion geben: Das geschieht auch auf Basis von Paar-Vergleichen.

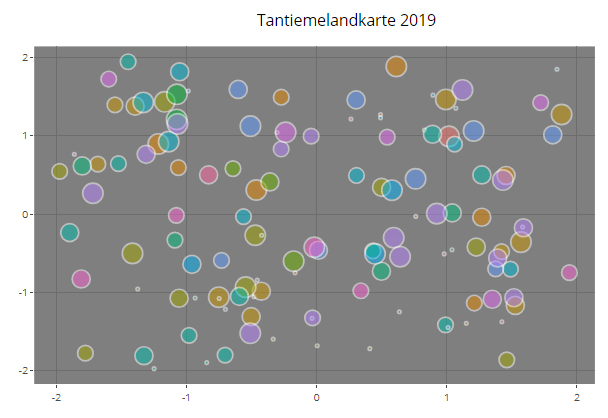

Den größten Beitrag hat dabei ein noch junges Verfahren gegeben, das die Anzahl der Dimensionen auf zwei reduziert, aber dabei versucht die Ähnlichkeit zwischen Datenpunkten zu erhalten (UMAP). Ergebnis ist eine interaktive „Karte“ der Mitarbeiterbewertungen (hier mit zufälligen Werten, eingefärbt nach deren Personalverantwortlichen).

„Besonders gut finde ich daran, dass hier eine Rückwärtssuche möglich ist: Wir können auf einen Blick kleine Cluster ähnlich bewerteter Personen sehen und uns dann fragen, ob diese zu Recht oder nur zufällig entstanden sind und dann in die Diskussion gehen.“ – Rita Helter

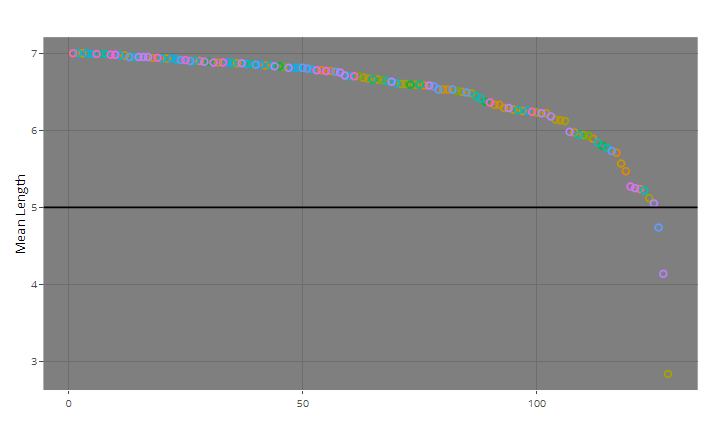

Darüber hinaus haben wir ein Verfahren zur Anomalie-Erkennung eingesetzt: den Isolation Forest. Grundidee hier ist, Entscheidungsbäume aufzubauen, die zufällig und mehrfach auf einem Bewertungskriterium die Daten aufspalten. Das machen wir so lange, bis alle "isoliert" sind (oder klar ist, dass sie identisch bewertet sind). Die mittlere Anzahl von Splits, die ein zufälliger Entscheidungsbaum-Wald im Durchschnitt braucht, um mich zu isolieren, sagt dann etwas darüber aus, wie typisch ich bewertet bin. Typische Fälle sind schwer zu isolieren. Echte Ausreißer bräuchten nur einen Split (bspw. „mehr Personalverantwortung als alle anderen“), wären aber auch ohne das Verfahren offensichtlich. Im Beispiel unten sind fast drei Splits notwendig, um die erste Bewertung zu isolieren. Man kann das Verfahren als eine Dimensionsreduktion auf eine einzige Dimension verstehen.

Ausreißer-Bewertungen sind dann sehr gut sichtbar und können hinterfragt werden (hier mit Echtdaten).

Massstäbe absichern

Weitere QS-Schritte sind dann sehr schnell gemacht: Bspw. versuchen wir, anhand der Bewertungen per Machine Learning rückwärts zu klassifizieren, von wem die Bewertungen stammen und woran sich der erlernte Klassifizierer orientiert – Explainable AI-Verfahren machen das möglich. Das gelingt dem Verfahren aktuell aber kaum und das ist auch gut so: Die Bewertenden haben ähnliche Maßstäbe.

Falls es doch gelingt, orientiert sich das Verfahren an Bewertungsaspekten, die viel Verantwortung implizieren. Das deutet auf erfahrene Mitarbeiter*innen hin und die werden auch tatsächlich erfahrenen Führungskräften zugeordnet – auch das ist gut so.

Nächstes Jahr wiederholen wir das Experiment.

„Es geht nicht darum, das bewährte Verfahren zu ersetzen. Die KI-Verfahren können uns valide Hinweise liefern, auf welche Punkte wir in der Konsolidierung besonders achten müssen. Das erleichtert die manuelle Arbeit, sodass diese auch bei weiterem Wachstum zu bewältigen bleibt.“ – Rita Helter.

zurück zur Blogübersicht