Intelligente Chat-Tools sind aus der modernen Arbeitswelt nicht mehr wegzudenken und Unternehmen bieten ihre produktivitätssteigernden Potenziale zunehmend gezielt ihren Mitarbeitenden an. Hierfür eignet sich insbesondere die Einführung einer eigenen, internen Lösung, um die sichere und datenschutzrechtlich konforme Nutzung der KIs zu gewährleisten. Denn ein fehlendes Angebot der intelligenten Helfer bedeutet meist die wesentlich riskantere Nutzung externer Dienste durch die Hintertür. Eine innovative AI Chat Plattform namens LibreChat erleichtert uns mit einer ChatGPT-ähnlichen Oberfläche die Einführung solcher KI-Tools: Das Open Source Produkt bietet Funktionen von intelligenten Chats bis zur Integration eigener GenAI-Anwendungen - und das alles ohne das Schreiben einer einzigen Zeile Code!

In diesem Blogbeitrag geben wir einen tieferen Einblick in LibreChat und teilen unsere Erfahrungen, die wir während der Implementierung von viadeeGPT auf Basis von LibreChat gesammelt haben.

Wieso benötige ich eine AI Chat Platform?

Im Alltag nutzen wir häufig einfache Chat-Funktionen, um beispielsweise Mails zu formulieren, Texte zu verfassen oder Code zu generieren. Oftmals geschieht dies jedoch ohne eine offizielle, unternehmensweite Freigabe, was potenzielle Sicherheitsrisiken in Bezug auf die Datensicherheit mit sich bringt. Ein wesentlicher Vorteil eigener AI Chat Platform besteht folglich darin, dass sie diese Risiken minimieren und Daten in eigenen Systemen verbleiben.

Zudem können sie optimal an das Unternehmen und seine Nutzer:innen angepasst werden, indem weitere GenAI Tools, wie Retrieval Augmented Generation (RAG) oder Agent Systems integriert werden. Anstelle einer losen Sammlung von Tools und Links im Unternehmen, findet sich somit eine zentrale Plattform mit einheitlicher Benutzeroberfläche, die alle gewünschten KI-Funktionalitäten integriert. Durch die Verhinderung eines unkontrollierten IT-Wildwuchses wird den Usern erleichtert, den Zugang zum richtigen Bot zu finden. Insgesamt wird durch eine solche Plattform also die User-Experience maßgeblich erhöht.

Ebenso erleichtert sich die Administration und das Deployment der Tools. Denn eine zentrale AI Chat Platform ist leichter zu warten und abzusichern als dezentralisierte Tools und erspart Erstellung und Wartung mehrerer UIs. Folglich verbessert sich die Sicherheit der Systeme.

Warum möchte man eine Open Source Lösung für KI-Chats nutzen?

Chat-Plattformen sind auch eine neue Produktkategorie mit vielen Spielern. Sie werden sowohl von den Anbietern der großen Modelle angeboten als auch von Dritten, um Modellunabhängigkeit herzustellen. Gleichzeitig bieten die Cloud-Provider solche Dienste ebenso an wie vermeintlich einfache Tools wie der Acrobat Reader.

Während die Kernfunktionen überall ähnlich aussehen, ist die strategische Sicht stark unterschiedlich: Ein Chat-Interface hat einen Plattform-Charakter. Es ist absehbar, dass ein Chat in ähnlicher Weise der Schlüssel zu vielerlei Diensten sein wird, wie es die Google-Suche bislang ist. Für die oben genannten steht daher in dieser Phase das Erzeugen von Lock-In-Effekten im Vordergrund. Das geschieht gerade vor allem durch Vor-Integration in alle möglichen Datenquellen und Werkzeuge.

Durch aktive Open Source-Produkte können sicherheitsbewusste Unternehmen sich diesem Sog entziehen und sie bleiben flexibel für die nächste Innovationsrunde. Die Schnittstellen zu Datenquellen und LLMs sind im Vergleich zu fachlichen Anwendungen maximal einfach (Input: Fließtext, Output: Fließtext) und davon sollten wir uns nicht durch schöne Marketing-Folien ablenken lassen, sondern können von den de-facto-Standards profitieren.

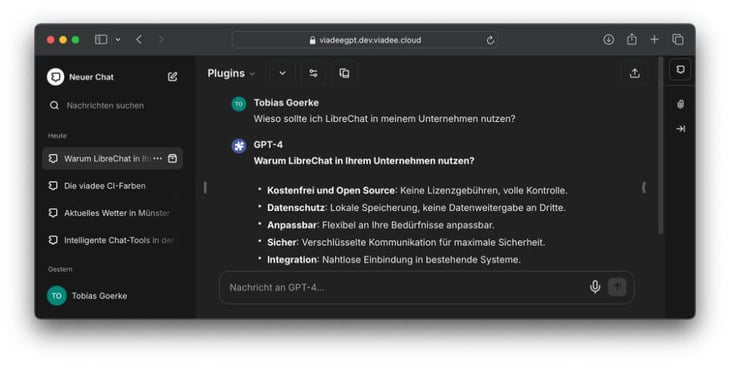

Die All-In-One-Plattform LibreChat

LibreChat konnte sich schnell einen Namen als AI-Chat-Plattform in der Open Source Community machen. Als kostenfreie Open Source-Lösung kann sie von jedem Unternehmen genutzt werden und ist dank ihrer wachsenden Community mit fast 16k GitHub Sternen schnell am Wachsen und gut gewartet. Die Benutzeroberfläche ähnelt der von ChatGPT, was neuen und KI-unerfahrenen Nutzern den Einstieg erleichtert. Durch die hohe Konfigurierbarkeit und Anpassbarkeit können verschiedene Large Language Models integriert werden, einschließlich lokaler Modelle oder solcher aus Cloud-Diensten wie Azure OpenAI, oder auch AWS Bedreck und GCP Vertex AI.

Dabei bietet LibreChat so ziemlich alle Features, die sich von einer AI-Chat-Plattform gewünscht werden könnten, wie beispielsweise Chat-Branching, Teilen von Chats, multimodale Chats, benutzerdefinierte Presets, Mandantenfähigkeit und Moderationswerkzeuge, u.v.m. Für uns jedoch liegt LibreChats Key-Feature im Plugin-System. Diese ermöglichen, die Chats durch beliebige Agenten oder Funktionen anzureichern. So können im Chat Bilder mit dem Bildgenerator DALL-E erstellt oder Antworten durch Internetsuchen und RAG-Funktionalitäten angereichert werden.

Erweiterbarkeit durch Plugins

Die mitgelieferten Plugins, wie DALL-E und Internetsuchen sind bereits sehr mächtig und nützlich. Dennoch genügen sie nicht für alle Chat-Systeme. Denn sobald wir ein eigenes Retrieval Augmented Generation oder Agent System entwickeln möchten, um unternehmensinterne Daten und Funktionen anzubinden, gelangen die Plugins an ihre Grenzen. In diesen Fällen haben wir die Möglichkeit, eigene Plugins bereitzustellen. Diese werden mit der Sprache des LangChain-Frameworks definiert und können beliebige Funktionalität ausführen. Die Ergebnisse des Tools werden zurück an das LLM gespielt, dass dann eine Antwort auf Basis der Informationen formulieren kann.

Als möglichst einfaches Beispiel nehmen wir ein Plugin, das die Farben der viadee Corporate Identity kennt und dem LLM bei Bedarf zur Verfügung stellt. Das Plugin muss lediglich dem LibreChat-Code hinzugefügt und aktiviert werden und steht fortan zur Verfügung. Der Plugin-Mechanismus erlaubt beliebige Erweiterungen des Anwendungsfalls, sodass wir weitere LLM-Systeme, wie bspw. unseren viadee Blog Assistenten leicht anbinden könnten. Auf diese Weisen lassen sich dann auch Chat-with-your-Data und RAG-Systeme anbinden.

Weiterer KI-tools können beliebig als Plugin in die LibreChat-Plattform integriert werden. Sie können das System mit Informationen anreichern und/oder mit externen Systemen kommunizieren.

Erfahrungsbericht: viadeeGPT

Wie bereits aus obigen Screenshots deutlich wird, nutzen wir LibreChat als Backbone für unser viadeeGPT. Die Plattform erfreut sich seit einigen Monaten reger Benutzung innerhalb der viadee und ermöglicht uns, den Datenfluss sensibler Anfragen zu kontrollieren. viadeeGPT integriert darüber hinaus mehrere KI-Tools, wie unser Chat-with-Confluence oder Datenbank-Agenten, die unsere Datenbanksysteme inspizieren und durchsuchen können, um so deren Inhalte auch in nicht technisch formulierten Anfragen aufbereiten zu können.

Konfiguriert wurde LibreChat die auf Azure OpenAI gehosteten Modelle zu verwenden, wodurch wir den Betriebsaufwand der KI-Modelle delegieren. Die verbleibenden Komponenten (UI & MongoDB) werden als Container bereitgestellt. Alle UI-Komponenten können dabei beliebig modifiziert werden, indem ein eigenes Container-Image auf Basis der Open Source Dateien gebaut wird. Dementsprechend ist ein Hosting in allen gängigen Umgebungen, wie Azure, GCP, AWS oder onprem möglich. Wir nutzen unser Kubernetes-Cluster für die Bereitstellung von viadeeGPT.

Der Betrieb erfolgt durch unser AI Platform Team, das gezielt die Einführung und Wartung unserer internen KI-Systeme beaufsichtigt. Setup, Konfiguration, Betrieb und Wartung gestalten sich überraschend unkompliziert und erfordern verhältnismäßig wenig Aufwand trotz Rollout an alle Kolleg:innen.

Sollten Sie sich nun fragen, wie Sie eine solche Plattform auch bei sich einführen können, dann kommen Sie gern auf uns zu! Wir beraten Sie, ob und wie Sie LibreChat als moderne AI Chat Platform in Ihrem Unternehmen einführen und nutzen können.

zurück zur Blogübersicht