Explainable Artificial Intelligence (XAI) zielt darauf, Verhaltensmuster von Machine-Learning-Modellen zu durchleuchten und diese in einer verständlichen Art und Weise zu vermitteln. Viele der Methoden sind schwer zugänglich. Dabei sollten doch gerade Nutzer ohne entsprechenden technischen Hintergrund ein Gefühl für die AI bekommen. ERIC ist ein Chatbot für Explainable AI. Er ist speziell entwickelt, um Fragen zu beantworten, die Nutzer von Machine-Learning-Modellen typischerweise stellen. Dazu führt ERIC eine Konversation in natürlicher Sprache an.

EXPLAINABLE AI

Explainable AI umfasst eine Vielzahl von Methoden, die das Verhalten eines Machine-Learning-Modells transparenter und nachvollziehbarer machen. So approximiert beispielsweise der Anchor Algorithmus bestimmte Verhaltensmuster eines Machine-Learning-Modells durch verständlichere Wenn-dann-Regeln. Ein Großteil der aktuellen Forschung konzentriert sich auf die Neu- oder Weiterentwicklung solcher Methoden – das Feld wird unübersichtlich. Diese Methoden lassen sich in den meisten Fällen lediglich in entsprechenden Programmierumgebungen ausführen, die Ergebnisse sind oftmals nicht aufbereitet und somit zunächst schwer greifbar für Machine-Learning-Laien.

Dabei ist es gerade wichtig, dass auch Nutzer ohne entsprechendes Programmier- und Machine-Learning-Know-how einen Zugang zu den Erklärungen bekommen, die Explainable AI bereitstellt. Ohne diesen Zugang können oftmals ausgerechnet die Nutzer, die von den autonomen Entscheidungen des Machine Learnings profitieren sollen, weder Vertrauen noch begründete Skepsis aufbauen.

Vertrauen – das ist ein essenzielles Gut beim Zusammenspiel zwischen Mensch und Computer. Doch wie können die Methoden und Algorithmen, die Explainable AI bereitstellt, effektiv eingesetzt werden, um ein transparentes Bild eines Machine-Learning-Modells und damit Vertrauen zu schaffen?

EINE INTERDISZIPLINÄRE SICHTWEISE

Welche Eigenschaften zeichnen eine gute Erklärung eigentlich aus? Um ein genaueres Bild von Erklärungen zu erlangen, lohnt es sich, einen Blick in die kognitiven Wissenschaften zu werfen, die den Begriff einleuchtend differenzieren. Demnach unterscheidet sich eine Erklärung als ein Produkt von einer Erklärung als ein Prozess.

Als Produkt ist eine Erklärung eine Aussage, typischerweise in sprachlicher Form, die sich auf eine explizite oder implizite Bitte um eine Erklärung bezieht – beispielsweise eine ausgewählte Antwort auf eine „Warum …?“-Frage. Als Prozess ist eine Erklärung zunächst eine Aktivität, mit der jemand ein oder mehrere Erklärungsprodukte erzeugt. Diese beziehen sich auf die spezifische Anfrage der Fragesteller und können beispielsweise einen Verweis auf die Ursache einer Wirkung beinhalten. In einem zweiten Schritt wird dieses Produkt der Fragestellerin in einer Konversation vermittelt – es wird „erklärt“. Es ist die Unterhaltung, ein zwischenmenschlicher Austausch, der theoretisch so lange geführt wird, bis der Fragesteller einen Zusammenhang ausreichend verstanden hat.

Welche wichtigen Anforderungen lassen sich diesen Erkenntnissen für den Einsatz von Explainable AI entnehmen?

- Erklärungen sind ausgewählt und präzisiert. Sie beziehen sich auf die spezifische Frage des Fragestellers und spiegeln selten den vollständigen Zusammenhang wider.

- Erklärungen sind interaktiv. Sie bilden ein Zusammenspiel zwischen dem Erklärenden und dem Fragesteller. Beide müssen sich aufeinander einstellen.

- Erklärungen sind kontinuierlich und iterativ. Erklärungen sind kein „single shot“. Sie enden theoretisch erst, wenn der Fragesteller ausreichend Informationen erlangt hat.

Es gibt eine Vielzahl von Möglichkeiten zum Design einer Schnittstelle zwischen Mensch und Computer. Eine Möglichkeit sticht in Bezug auf die oben erwähnten Eigenschaften besonders heraus: der Chatbot. Chatbots bieten einen sprachbasierten Systemzugang in Form eines Dialogs mit dem Nutzer. Gegenüber statischen GUIs ermöglichen diese einen bidirektionalen Informationsfluss, wodurch Informationen individuell an den Nutzer angepasst werden können. Chatbots leben zudem von einem interaktiven Zusammenspiel mit dem Nutzer und simulieren dazu eine anhaltende natürliche Konversation.

ERIC: EIN CHATBOT FÜR EXPLAINABLE AI

Im Rahmen eines wissenschaftlichen Projektes hat die viadee einen Chatbot für Explainable AI entwickelt - ERIC. ERIC steht für „Explainable AI through rule-based interactive conversation”. Der Chatbot wendet verschiedenste Methoden aus dem Bereich Explainable AI auf ein Machine-Learning-Modell an und nutzt die Ergebnisse, um ein Set von Fragen zu beantworten, die Nutzer von Machine-Learning-Modellen typischerweise stellen.

Diese Fragen sollen ein nützliches Bündel an Funktionen darstellen, mit denen die Entscheidungen eines Machine-Learning-Modells ausgiebig untersucht werden können. Dazu zählen unter anderem:

- „Warum wurde in diesem Fall X vorhergesagt? (WHY)“,

- „Warum wurde nicht Y vorhergesagt? (WHY NOT)“,

- „Was muss geändert werden, um Y vorherzusagen? (HOW TO)“,

- „Wann wird Y vorhergesagt? (WHEN)“.

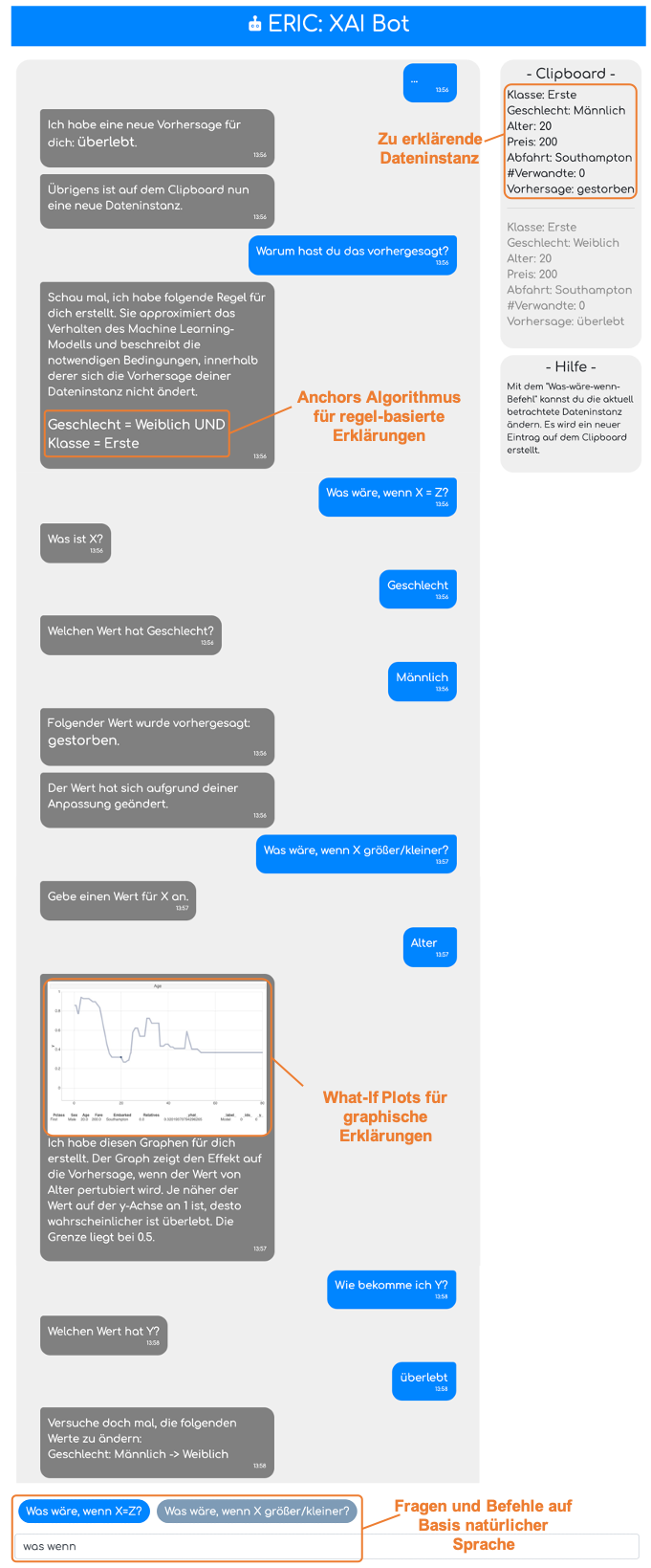

Für jede dieser Fragen bietet Explainable AI mindestens eine zugehörige Methode, beispielsweise Anchors, What-if-plots oder Shapley Values. Die Zuordnung von Fragen zu Methoden braucht Expertenwissen. Manche Verfahren sind im Einzelfall gar nicht anwendbar. ERIC enthält dieses Expertenwissen in einem regelbasierten System. Das regelbasierte System ist für die Durchführung des Dialoges mit dem Nutzer verantwortlich, in welchem Parameter abgefragt und Antworten übermittelt werden.

Auf diese Weise ist es auch recht einfach möglich, ERIC neue XAI-Verfahren beizubringen.

ERIC wurde als Client-Server Applikation entwickelt und ist zunächst auf die Erklärung von Klassifikationsmodellen für tabellarische Daten spezialisiert – den Fall, den viadee am häufigsten bei Kunden im Einsatz sieht.

ERIC: Erklärung eines Beispiel-Prognosemodells auf dem Titanic-Datensatz

In einem Beispiel wird ERIC mit einer Support Vector Machine (SVM), trainiert auf dem berühmten Titanic-Datensatz, konfrontiert. Der Datensatz beinhaltet Passagiere der Titanic-Katastrophe von 1912. Die Features im Beispiel sind: (Kabinen-) Klasse, Geschlecht, Alter, Preis, Abfahrt (Hafen) und Anzahl der auf dem Schiff befindlichen Verwandten. Das Machine-Learning-Modell kann für einen Passagier und dessen Merkmale vorhersagen, ob dieser in der Katastrophe gestorben wäre oder diese überlebt hätte. Im Beispiel findet der Nutzer erste Anzeichen, dass weibliche Passagiere der ersten Klasse sowie junge männliche Passagiere eine höhere Überlebenschance haben: „Frauen und Kinder zuerst!“.

ERIC: Ausblick

ERIC ermöglicht es einem Nutzer, die verschiedenen Verhaltensmuster eines Machine-Learning-Modells systematisch zu ergründen. Der Chatbot umfasst einige XAI-Methoden: darunter Anchors, Shapley Values und What-if-plots. ERIC befindet sich derzeit unter aktiver Entwicklung. Wir planen, die Interaktion mit ihm noch flexibler zu machen und mehr XAI-Methodenwissen zu integrieren.

Eine Live-Demo finden Sie auf unserem YouTube Channel:

Das zugehörige OpenSource-Projekt finden Sie auf GitHub:

https://github.com/viadee/eric

Ein erstes Forschungspaper wurde bereits veröffentlicht:

http://ceur-ws.org/Vol-2578/ETMLP3.pdf

Sie haben Fragen oder Feedback? Sehr gerne!

Sprechen wir auf dem Navigate AI Day am 12.05.2020 darüber?

Hinweis: Dieser Artikel fasst im Wesentlichen Erkenntnisse aus der Master-Thesis von Christian Werner (WWU) zusammen.

zurück zur Blogübersicht